入门指南:如何快速创建同步任务来导入数据

适用场景

如果您的数据存储在数据库、对象存储等系统上,需要导入到 Lakehouse 进行处理和分析,则适合阅读本文档。如果您需要导入存在本地文件中的数据,可以直接参考 如何快速上传导入本地数据,会更加便捷。

前置阅读

在阅读本指南之前,建议先阅读并理解以下文档:

操作指南

您可以通过 Lakehouse Studio 提供的「同步任务」功能,将数据库、对象存储等系统上的数据同步导入到 Lakehouse 中。本文以MySQL作为源端为例进行介绍。

使用说明

- 同步任务采用从源端拉取数据的方式,依赖源端数据源网络可达性。建议使用具备公网访问能力的数据源进行功能体验。在复杂网络情况下,例如需要同步 VPC 内的数据库数据,需要进行网络打通,可参考 利用 PrivateLink 通过 VPC 网络同步 RDS 数据(阿里云) 文档详细了解。

- 需要具备

工作空间管理员角色(workspace_admin)或工作空间开发角色(workspace_dev)权限的用户,才能使用「同步任务」功能。

操作步骤

-

如下图所示,点击按钮进入 Lakehouse 服务实例:

-

导航到「开发」页面:

-

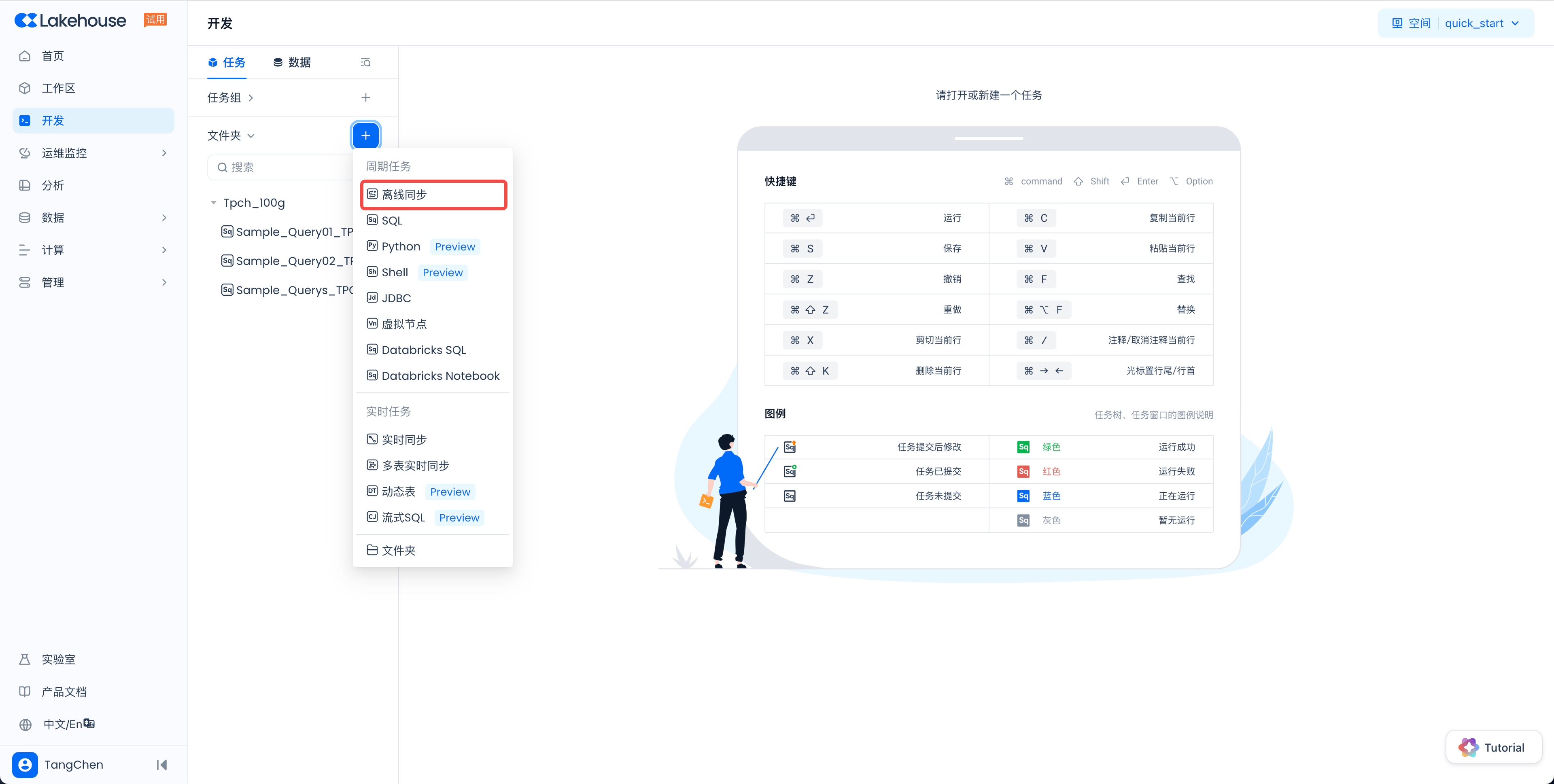

在左侧目录树,文件夹区域,点击 + (新建)按钮,在菜单中选择「离线同步」任务类型:

-

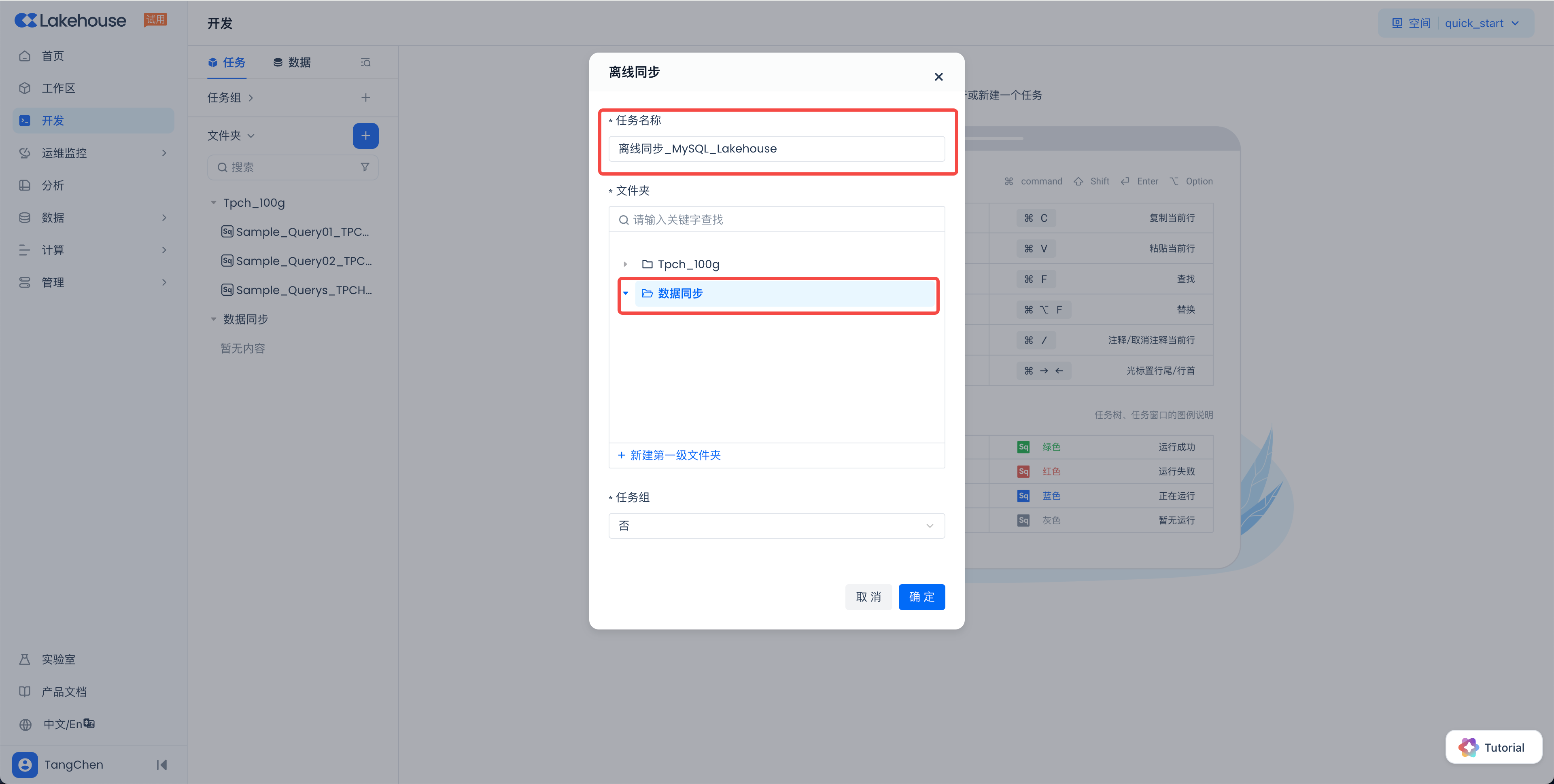

在弹框中,输入任务名称(可创建一个文件夹,非必须),点击“确定”。

-

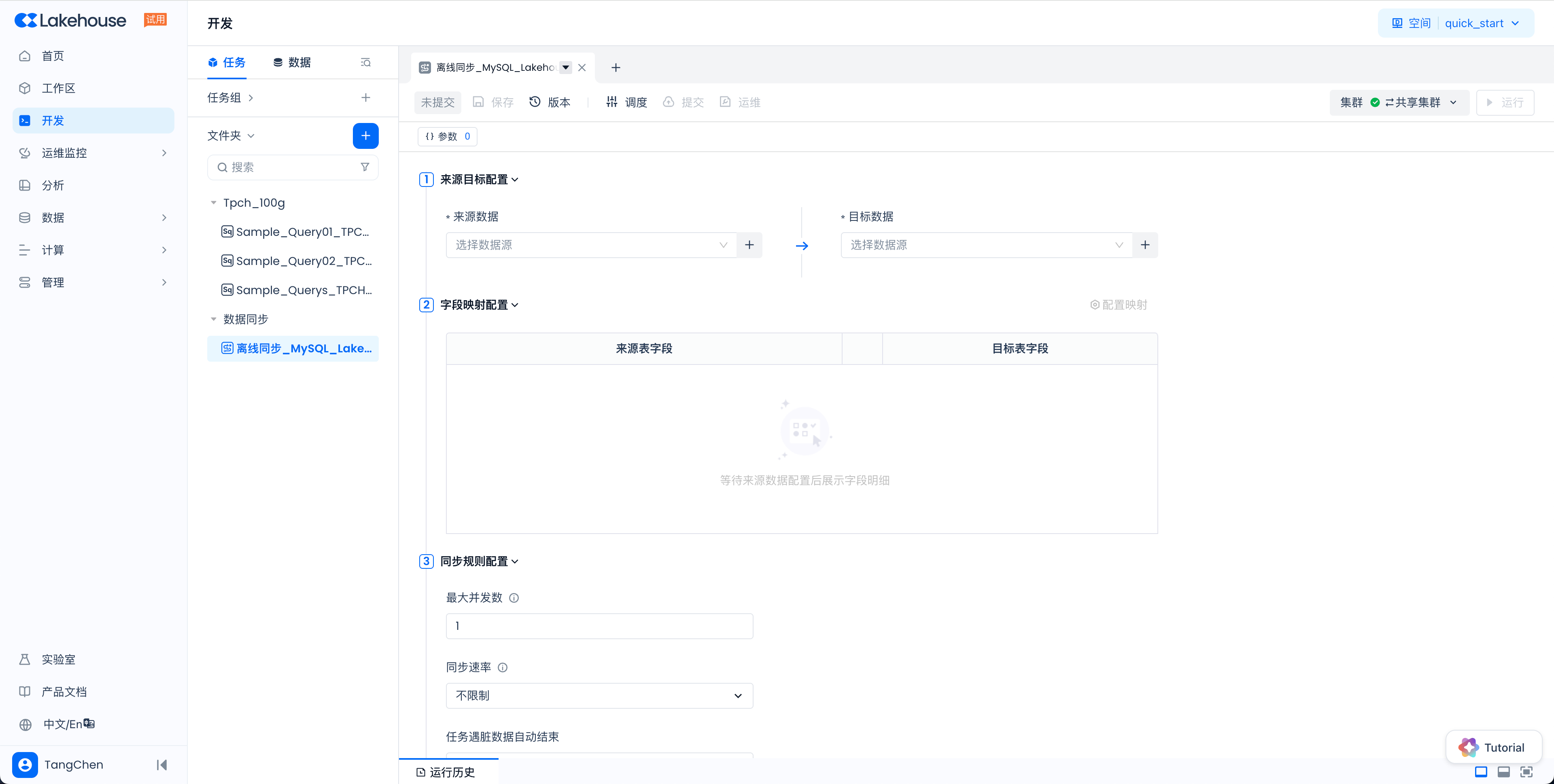

在页面上即可看到新建的同步任务,如下图所示:

-

开始配置同步任务的必填信息,核心是配置来源和目标端的信息。 备注:此处需要理解“数据源”概念。“数据源”是定义外部服务连接信息的对象,包括服务地址、认证信息、连接方式等。定义好的数据源可以在数据同步任务中作为数据来源或数据目标端使用。

-

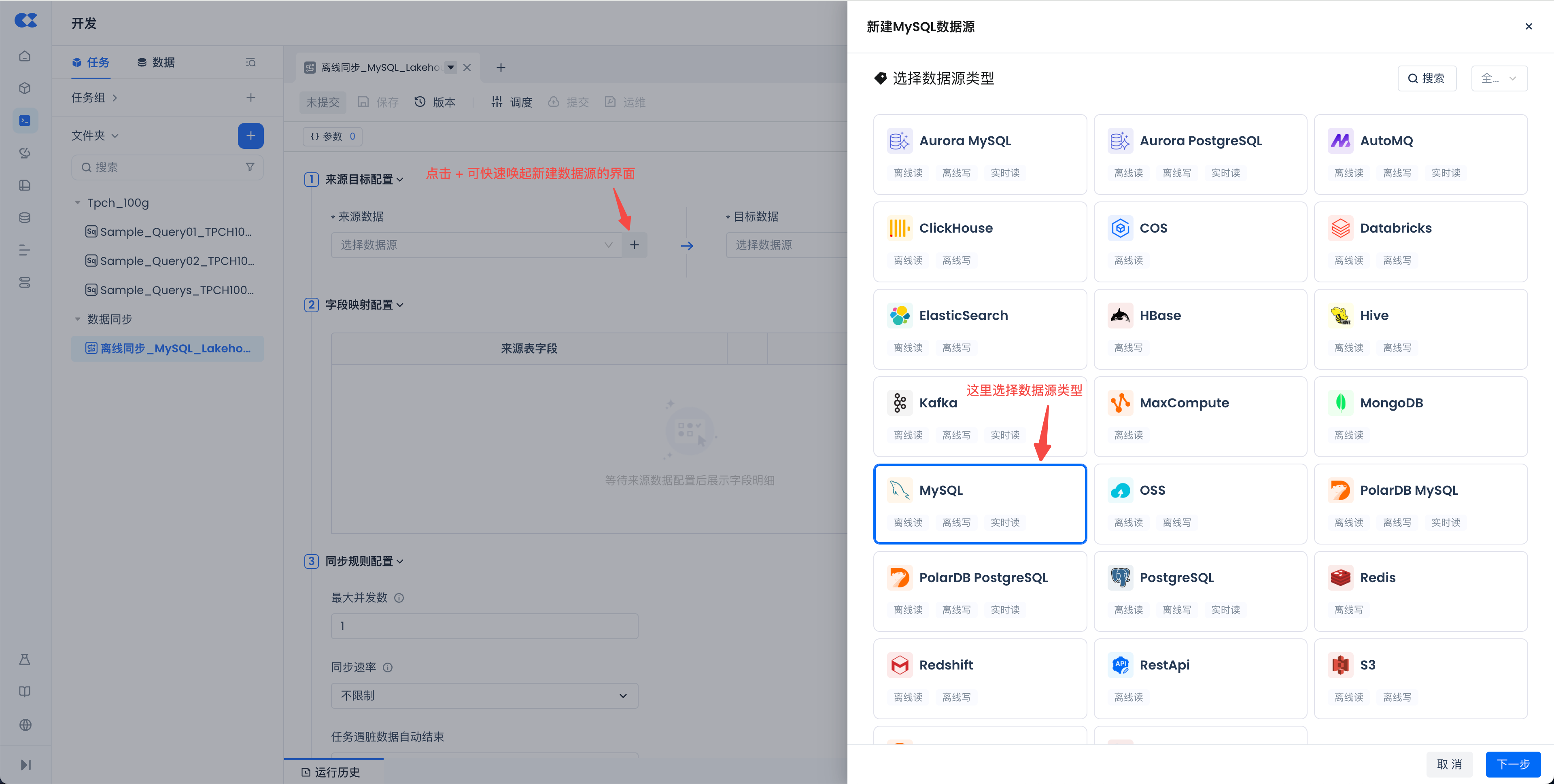

源端配置如下图所示,点击“+”后可以快速唤起新建数据源的界面:

-

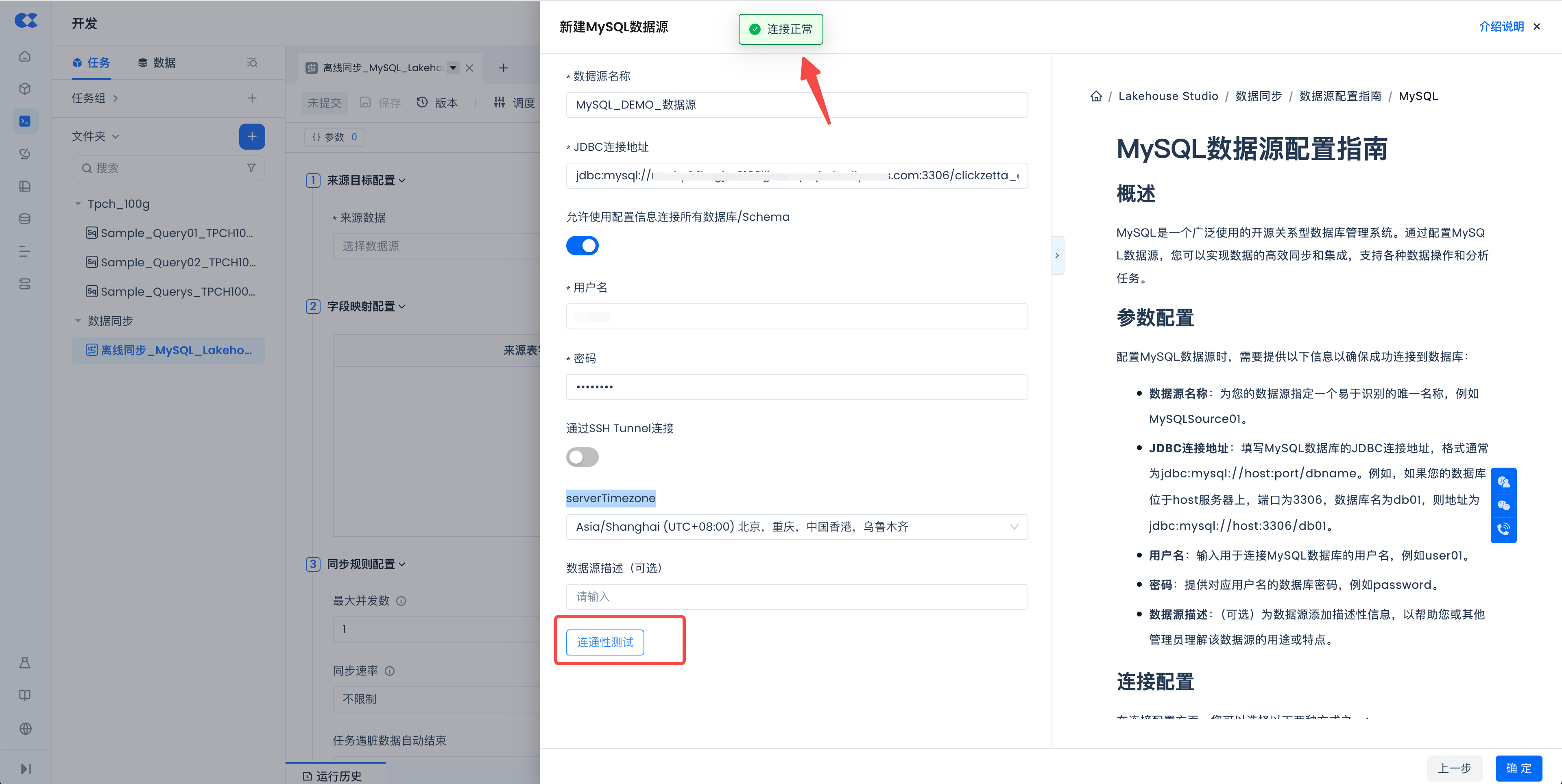

选择需要导入的数据源类型,本示意中选择MySQL,点击“下一步”进入详情配置页面。右上角的“使用说明”中,配套了详细的配置指南,如下图所示。请确保填写的 JDBC 连接地址、用户名和密码正确。serverTimezone 配置项是指数据库所在的时区,会影响同步到目标端后日期和时间字段的取值,请根据实际情况正确选择。

-

完成数据源的必填信息配置后,可以点击“连通性测试”按钮来测试数据源是否可以连通访问。测试连通正常如下图所示。如果不能连通,请检查网络和配置信息是否准确。测试通过后,点击右下角的确定进行保存。

-

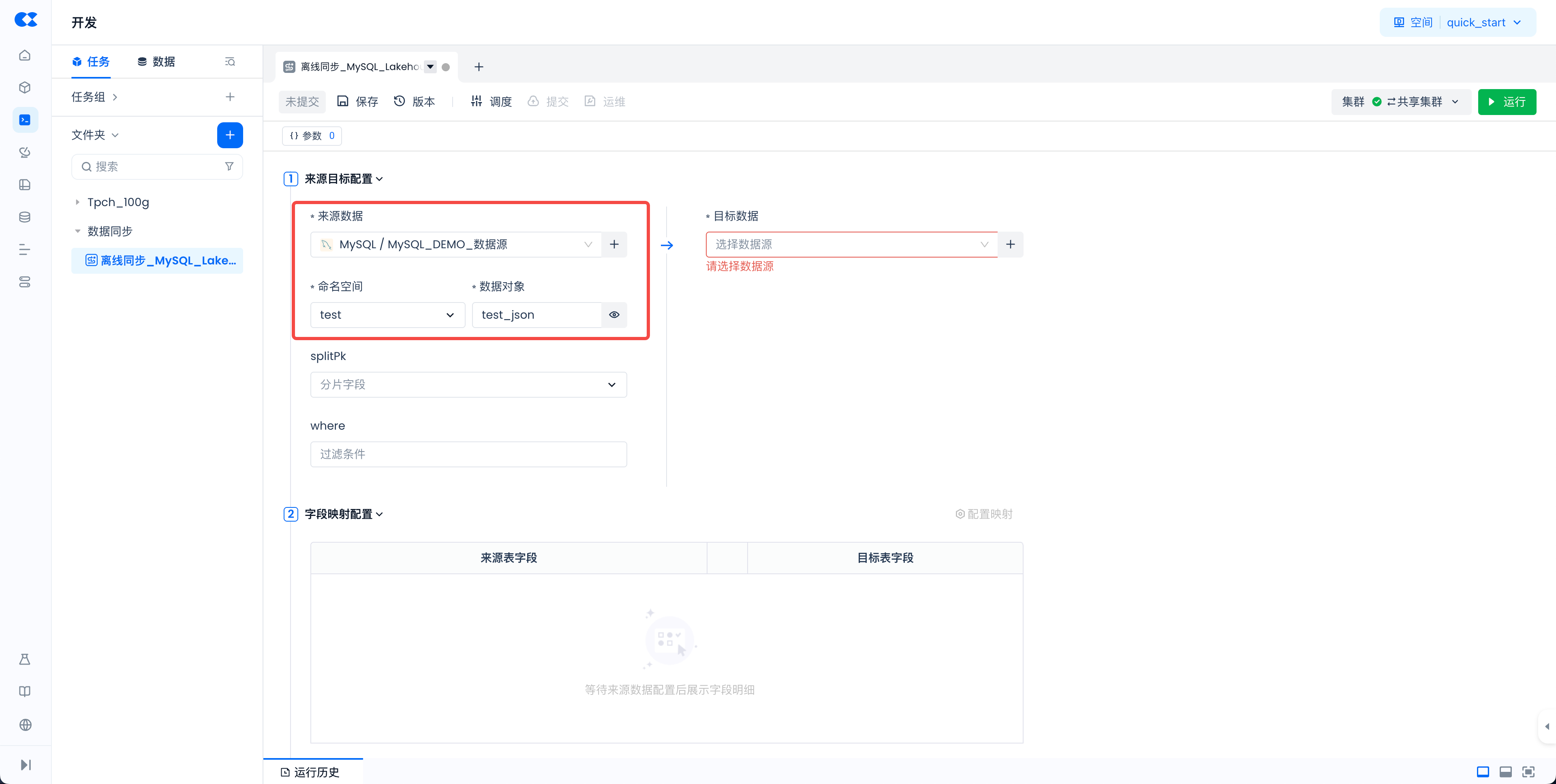

完成数据源创建后,回到同步任务配置页面,选择该数据源作为源端(如果没有自动展示,请重新打开任务),并选择命名空间(即数据库)和数据对象(即表),其他配置项可留空。

-

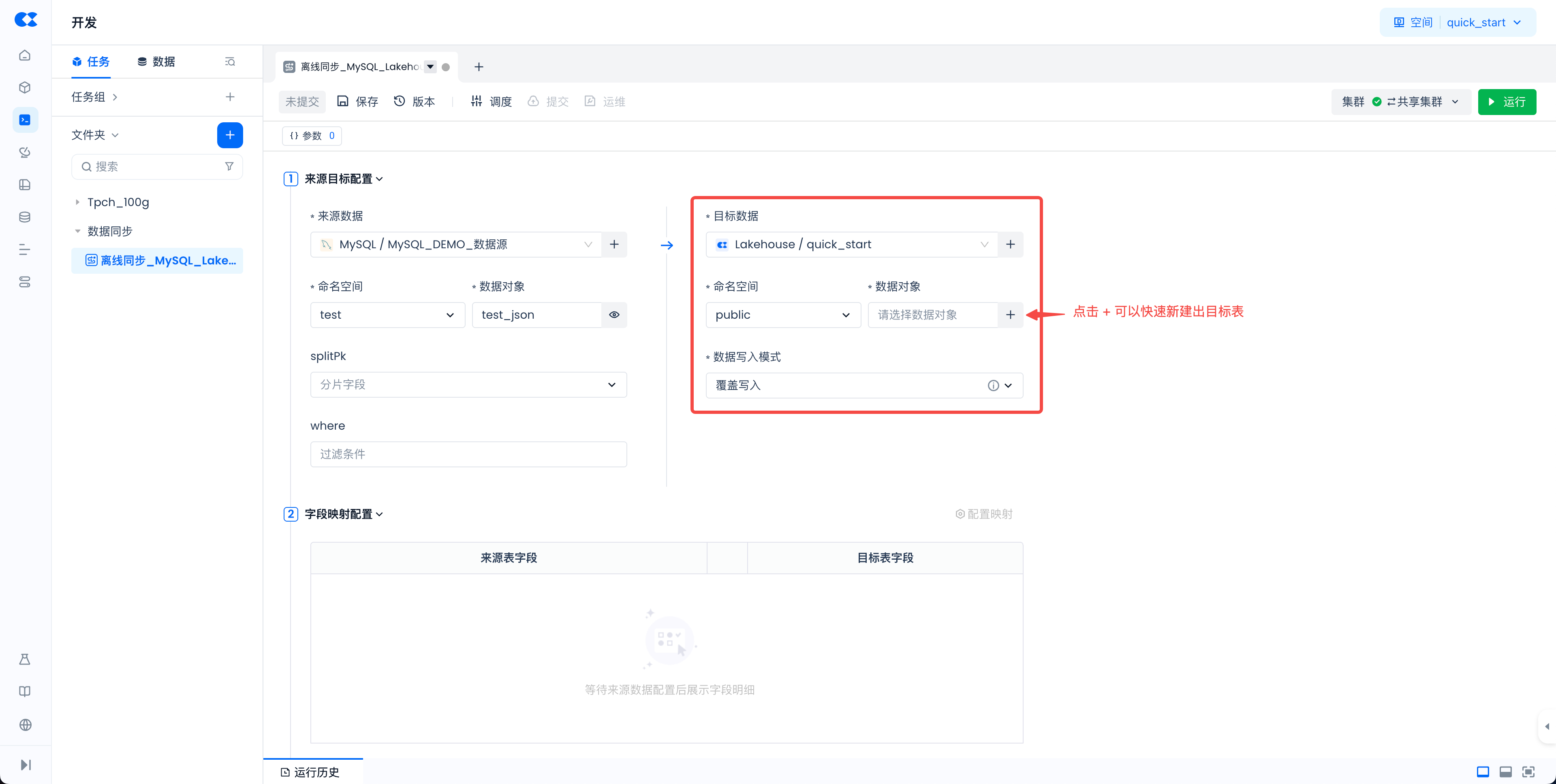

完成源端配置后,进行目标端的配置,如下图所示:

1). 选择Lakehouse数据源类型

2). 选择内置的 quick_start 工作空间(可类比理解为 database)。

3). 选择 public 命名空间(即:schema)

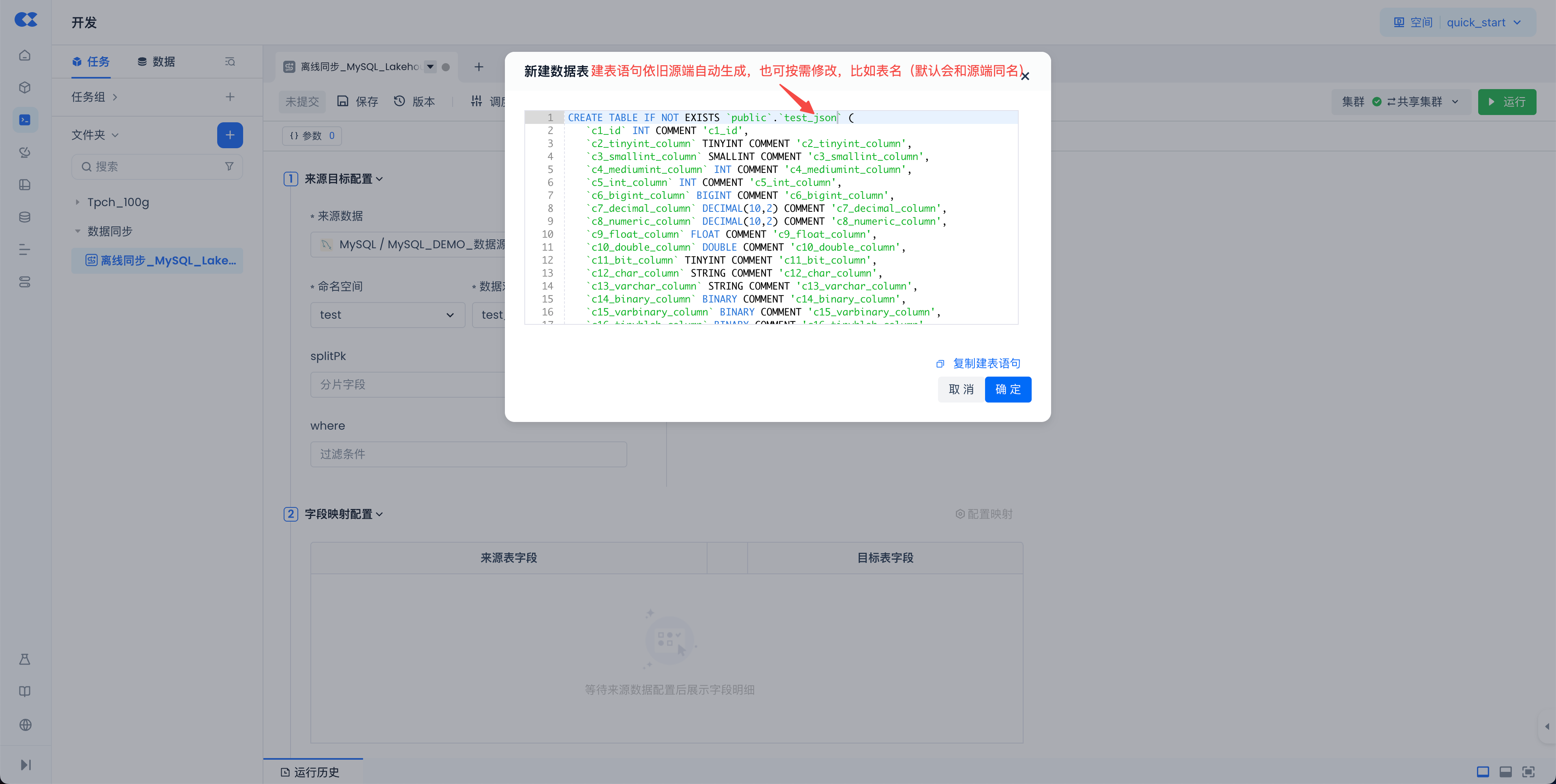

4). 数据对象,可以通过 + 按钮,快速新建目标Lakehouse表,在弹框中核对表的命名和schema信息后,点击“确定”按钮,完成表的创建。

5). 数据写入模式选择“覆盖写入”,即在同步前会先清空目标表中的数据,再写入从源端获取的数据。

-

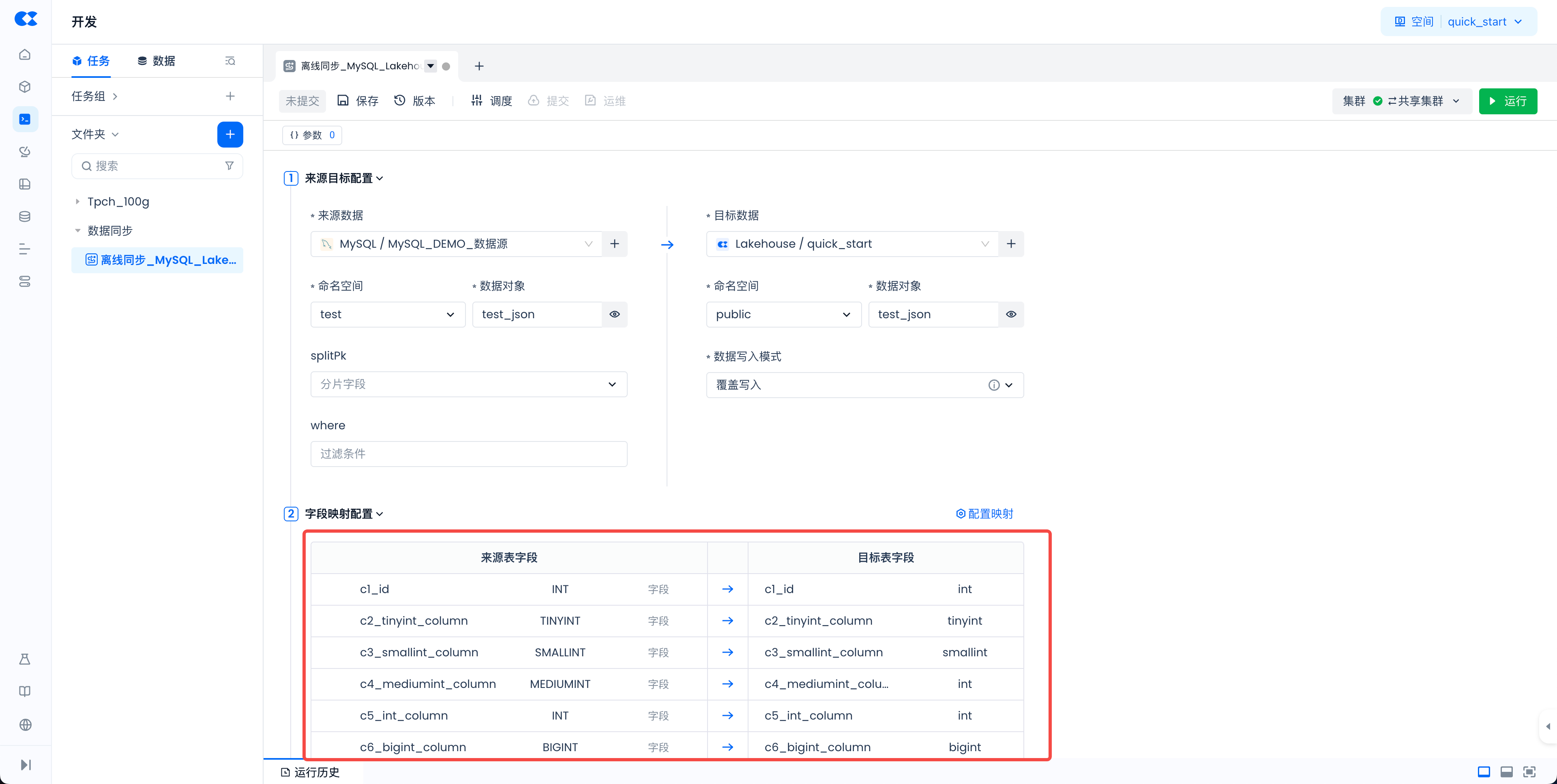

完成上述步骤后,在“字段映射配置”中会自动展示源端表和目标表的字段映射关系(默认是同名映射)。此处使用默认方式即可,无需修改。

-

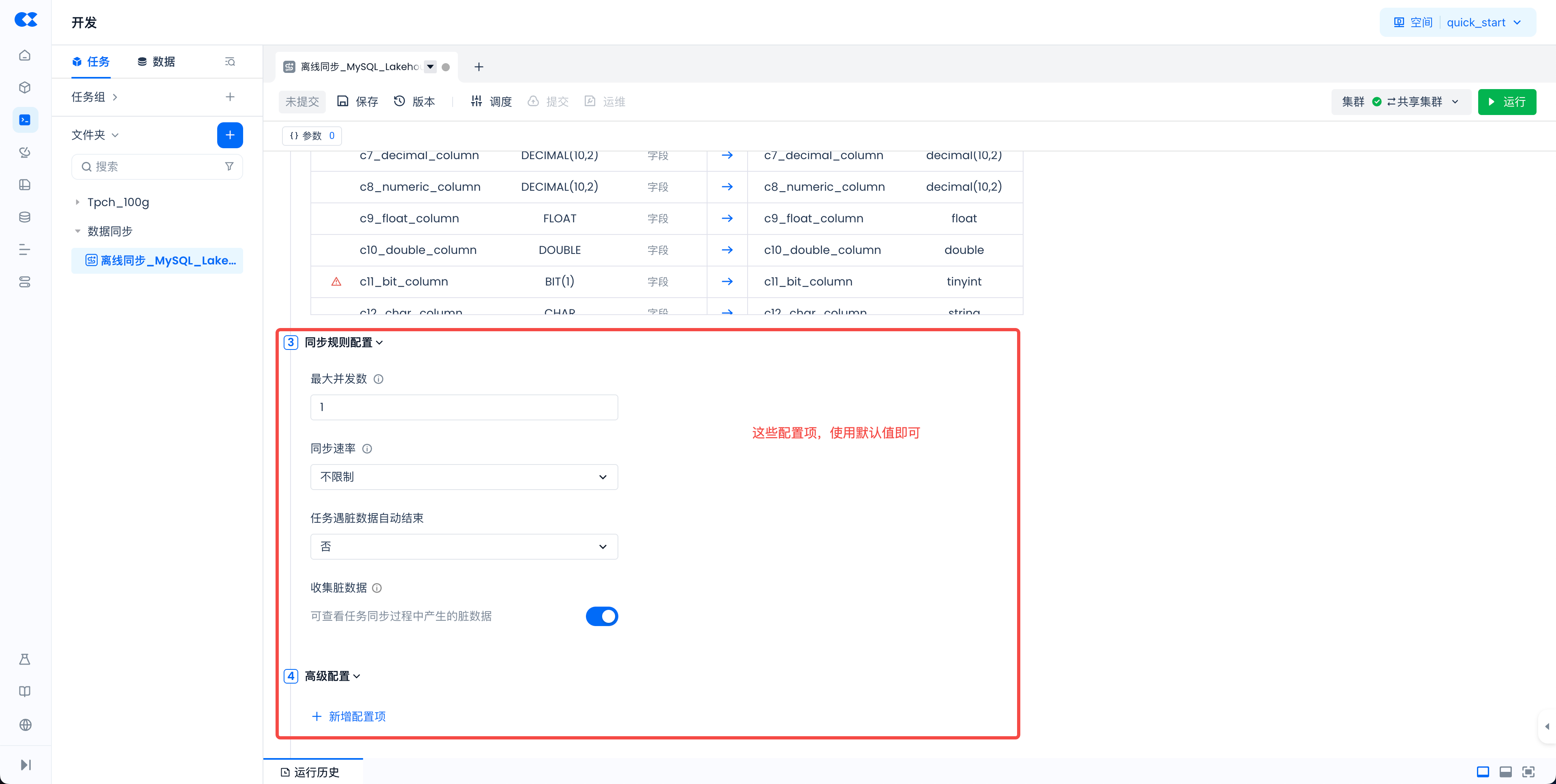

其他配置项,例如同步规则配置、高级配置等,使用默认值即可。

-

点击任务配置区域上方的“保存”按钮,保存任务的全部配置。

-

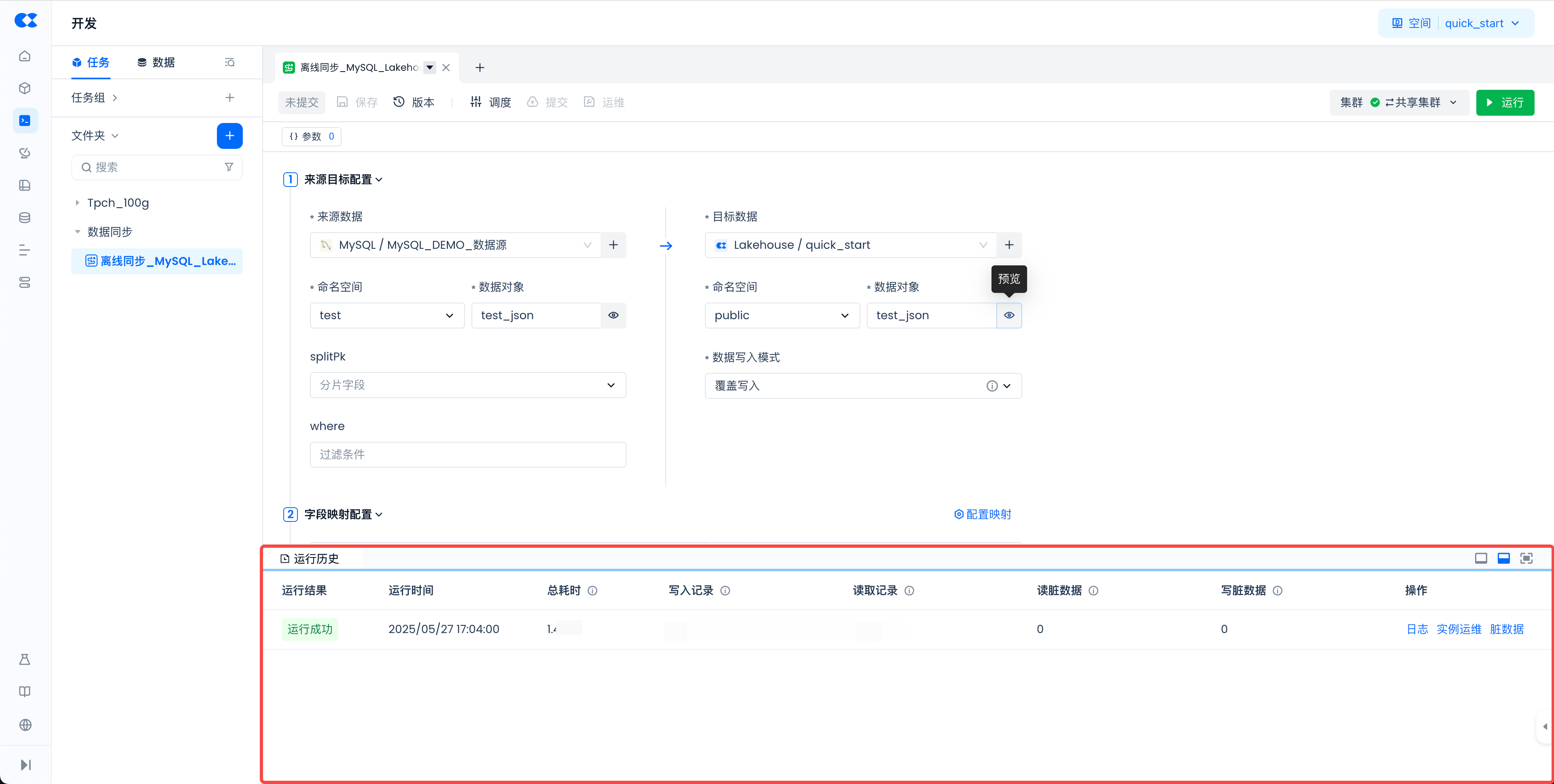

点击右上角的“运行”按钮,运行测试并触发数据同步(集群选项使用默认值即可)。

-

在页面右下角的“运行历史”区域,可以查看到任务的运行情况。

注:如果想测试同步速度,建议使用数据量相对较大的表进行测试,以降低任务启动时间带来的影响。

-

至此,就完成了一个同步任务的创建和运行,将 MySQL 的数据导入到了 Lakehouse 中。接下来可以基于导入的数据做后续分析和处理加工。

相关文档

- 您可以阅读 数据同步 | 文档目录 的文档来了解数据同步任务的完整使用指南。

- 您可以阅读 将数据导入Lakehouse的完整指南 来全面了解将数据导入到Lakehouse中各种方式。

下一步建议

- 完成数据上传之后,可以参考 如何快速运行一个SQL 的指南文档,对导入到表中的数据进行查询分析。